|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

메타가 토큰 대신 바이트를 사용하는 새로운 대형언어모델(LLM) 아키텍처 'BLT(Byte Latent Transformer)'를 공개했다.

메타는 최근 홈페이지를 통해 토큰 대신 바이트로 작동하는 LLM을 위한 'BLT' 아키텍처에 대한 논문을 발표했다.

BLT는 기존의 바이트 단위 LLM이 겪고 있던 문제들을 해결하기 위해 고안됐다.

BLT는 토크나이저가 없이 원시 바이트에서 직접 학습하는 아키텍처로, 고정된 어휘를 사용하지 않아 변화에 유연하게 대응할 수 있다는 설명이다. 대부분 LLM은 미리 정의된 토큰 집합을 사용해 훈련되며, 추론 시 입력을 토큰으로 나눠 모델에 전달한다. 이 방식은 계산 자원을 효율적으로 사용하지만, 모델 어휘에 포함되지 않은 토큰을 처리할 때 성능이 저하될 수 있다.

예를 들어, 웹에서 사용 빈도가 낮은 언어가 모델의 어휘에 포함되지 않으면 모델 속도가 느려지고 비용이 더 들 수 있다. 또 잘못된 철자는 입력을 부정확하게 토큰화, 문제를 일으킬 수 있다. 여기에 토큰화 모델은 문자 수준의 작업에서도 어려움을 겪는다.

이 경우 어휘를 수정하려면 모델을 재훈련해야 하고, 어휘를 확장하려면 모델 아키텍처를 변경해야 한다.

대신 LLM을 바이트 단위로 훈련하면 많은 문제를 해결할 수 있다는 설명이다. 물론 바이트 단위 LLM은 사전 훈련에 많은 비용이 들고, 긴 시퀀스를 처리하기 어렵다는 한계가 있다. 그래서 현재 대부분의 LLM은 여전히 토큰화를 필수적으로 사용한다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

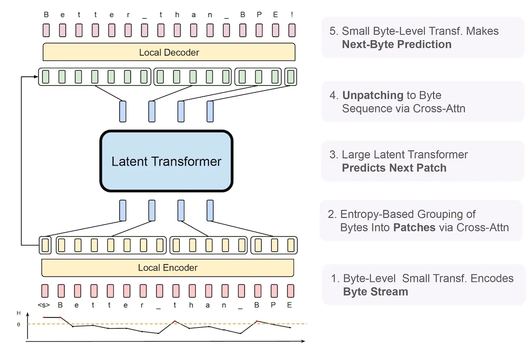

메타는 이런 바이트 단위 LLM의 비효율성을 해결하기 위해 정보량에 따라 바이트를 동적으로 그룹화하는 방법을 사용했다.

BLT는 고정된 어휘를 사용하지 않고, 바이트를 그룹화해 패치로 변환한다. 이 과정을 '동적 패칭(dynamic patching)'이라고 부르며, 두개의 소형 바이트 인코더 및 디코더 트랜스포머 모델과 하나의 대형 '잠재 글로벌 트랜스포머(latent global transformer)'로 구성된 새로운 아키텍처를 통해 구현된다.

인코더와 디코더는 가벼운 모델로 설계된다. 인코더는 원시 바이트 데이터를 입력받아 패치 표현을 생성하고 이를 잠재 글로벌 트랜스포머로 전달한다. 디코더는 이를 받아 다시 원시 바이트로 변환한다. 잠재 글로벌 트랜스포머는 패치 표현을 받아 시퀀스에서 다음 패치를 예측하고, 디코더는 이를 풀어 바이트로 변환한다.

잠재 글로벌 트랜스포머는 훈련과 추론에서 가장 많은 자원을 소모하는 부분으로, 패치 방식은 이 모델의 사용 방식을 결정하고 입력과 출력에 얼마나 자원을 할당할지를 조절할 수 있다.

기존 LLM에서 어휘 크기를 늘리면 토큰 크기가 커져 처리 속도는 빨라지지만, 트랜스포머 내부 구조가 커져 더 많은 자원을 필요로 한다. 반면, BLT는 어휘 크기와 상관없이 데이터 복잡도에 맞춰 자원을 조절할 수 있다.

예를 들어, 단어의 끝부분은 예측하기 쉬워 적은 자원이 필요하지만, 새로운 단어나 문장의 첫 단어는 더 많은 연산이 필요하다.

연구진은 "BLT는 고정된 비용 내에서 모델과 패치 크기를 동시에 확장할 수 있어 실제 환경에서 더 효율적"이라고 설명했다.

BLT와 기존 트랜스포머 모델을 비교하기 위해 4억~80억개 매개변수를 가진 다양한 모델을 실험했다. 그 결과, 훈련에 필요한 자원을 동일하게 할당했을 때 BLT는 '라마 3'와 비슷한 성능을 보이면서 추론 시 최대 50% 적은 FLOP을 사용했다. 이는 BLT 모델이 바이트 그룹을 길게 만들어 연산을 절약하고, 그 자원을 글로벌 잠재 트랜스포머의 크기 확장에 사용할 수 있기 때문이다.

BLT 모델은 효율성뿐만 아니라, 노이즈가 있는 입력에 더 잘 반응하고 문자 수준에서의 이해 능력이 향상됐다. 또 문자 조작이나 저자원 기계 번역에서 더 좋은 성능을 보였다.

연구진은 "BLT가 원시 바이트를 직접 처리함으로써 데이터에서 자주 나타나지 않는 패턴을 더 잘 모델링할 수 있다"라며 "전반적으로 패치와 모델 크기를 동시에 늘려 토큰화 기반 모델보다 상당히 더 나은 확장성을 보여준다"라고 밝혔다.

박찬 기자 cpark@aitimes.com

<저작권자 Copyright ⓒ AI타임스 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.