|

삼성전자가 개발한 CXL 2.0 지원 D램./삼성전자 제공 |

<이미지를 클릭하시면 크게 보실 수 있습니다> |

삼성전자가 챗GPT에 특화한 새로운 메모리 인터페이스인 컴퓨트익스프레스링크(CXL) 관련 IP(설계자산) 확보에 나섰다. 인공지능(AI)에 특화한 메모리 반도체인 고대역폭메모리(HBM)에 이어 새로운 먹거리가 될 CXL 기술은 대규모언어모델(LLM)의 초고속 데이터 처리를 위한 차세대 인프라로 꼽힌다.

12일 업계에 따르면 삼성전자는 지난해 CXL 1.0 모델에 이어 CXL 2.0까지 개발을 완료된 상황이며, CXL 3.0 개발을 위해 국내외 반도체 IP 기업들과 협업하고 있다. 이르면 내년부터 아마존웹서비스(AWS), 마이크로소프트(MS) 등 대형 클라우드 고객사들에 CXL 솔루션을 시연하고 제품 공급을 추진한다는 방침이다.

CXL이란 데이터센터의 두뇌 격인 중앙처리장치(CPU) 혹은 가속기 역할을 하는 그래픽처리장치(GPU)와 메모리 반도체 사이의 도로를 기존 2~3차선에서 8차선, 10차선 이상으로 대폭 늘리고 효율화하는 최신 인터페이스 기술이다. CPU와 메모리 반도체 사이의 병목 현상을 구조적으로 개선하는 인터페이스를 구축할 수 있고, 서버의 메인 메모리 용량과 성능을 비교적 낮은 비용에 높일 수 있다는 강점이 있다.

업계에 따르면 삼성전자는 현재 CXL 제품을 크게 세 가지 종류로 나눠 개발하고 있으며 이 중에서 가장 진보한 형태의 메모리 아키텍처인 CXL 3.0에 역량을 집중하고 있다. CXL 3.0은 다수의 메모리 반도체를 패브릭(Fabric) 형태로 연결해 거대한 공유 메모리 풀(pool)을 형성하는 기술이다.

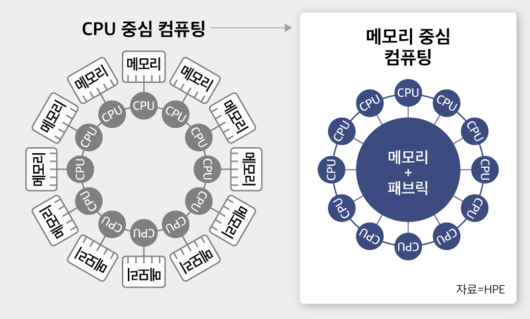

기존 컴퓨팅 구조에서는 CPU와 메모리가 하나의 블록으로 분리돼 있다. 개별적인 CPU와 메모리가 수직적으로 연결돼 있는 것이다. 반면 인공지능(AI) 기능을 효율적으로 이용하기 위해서는 CPU가 다른 CPU의 메모리에 직접 접근할 수 있도록 하는 병렬화가 중요하다. CXL 3.0에서는 다수의 CPU가 하나의 메모리 풀을 공유하는 형태로 발전해 데이터 처리 속도가 비약적으로 높아진다.

|

기존의 CPU 중심으로 설계된 서버(왼쪽)와 CXL 3.0 기술을 적용한 서버. |

<이미지를 클릭하시면 크게 보실 수 있습니다> |

CXL 3.0보다 더 개발이 진전된 상태인 CXL 2.0 기술은 기존 DDR 기반의 인터페이스를 바꿔 서버의 D램 용량을 획기적으로 늘리고 칩 간 데이터 전송 속도를 끌어올릴 수 있다. 현재 D램 분야에서는 DDR이라는 인터페이스가 표준으로 사용되고 있는데 DDR 기반 D램은 물리적으로 CPU 1개에 연결할 수 있는 모듈 개수가 16개로 제한돼 있다.

삼성전자는 CXL 2.0으로 서버 구조를 바꿔 모듈 개수를 8배~10배 수준으로 늘리는 한편 비휘발성인 플래시메모리도 탑재하는 방향으로 기술 개발을 진행하고 있다. CPU와 가까운 곳에 더 많은 비휘발성 데이터를 저장할 수 있게 되면서 ‘인메모리(In-Memory) 프로세싱’이 가능해지고 이는 CPU, GPU의 효율을 극대화할 수 있다. 현재 삼성전자가 개발한 CXL 2.0 모델의 경우 메타가 운용하고 있는 언어학습모델보다 2~3배 이상의 속도 개선에 성공한 것으로 알려졌다.

국내 IP업체 관계자는 “기존의 데이터센터들은 거대한 메모리 시스템을 구축하기 위해 별도의 CPU를 탑재한 메모리 서버를 설치해야 하는데 CXL 시스템에서는 CPU 아래에 스위치를 연결해 필요한 메모리를 레고 블록 조립하듯이 넣을 수 있다”며 “단순히 기술적으로 진보한 것 뿐만 아니라 비용 절감 측면에서 CXL이 각광받고 있다”고 설명했다.

황민규 기자(durchman@chosunbiz.com)

<저작권자 ⓒ ChosunBiz.com, 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.