과학자들이 공상과학(SF) 영화에서 생각을 읽던 기계를 현실로 만들고 있다. 인공지능과 뇌과학을 이용해 머리로 생각한 말은 물론, 기억 속의 영상까지 복원하고 있다. 기술이 발전하면 지난해 세상을 떠난 호킹 박사처럼 온몸이 마비된 환자도 자유롭게 의사소통을 할 수 있을 것으로 기대된다.

◇입술에 보낸 뇌 신호로 음성 합성

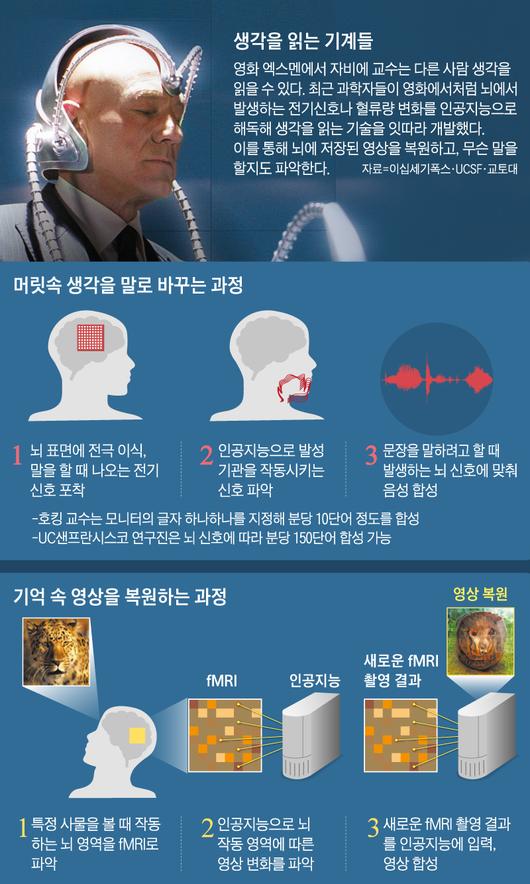

창 교수 연구진은 간질병 치료를 위해 뇌에 우표 크기의 전극을 이식한 환자 5명에게 '이상한 나라의 앨리스'와 '잠자는 숲 속의 미녀'에 나오는 문장 수백 건을 소리 내서 읽도록 했다. 전극은 이때 뇌에서 혀나 입술, 턱 등 발성기관으로 보내는 운동 신호를 포착했다.

데이터 분석은 인공지능이 맡았다. 이를 통해 뇌가 특정 음성을 내려고 할 때 어떤 형태의 신호들을 발성기관에 보내는지 알아낼 수 있었다. 마지막은 음성 합성이다. 인공지능이 뇌에서 포착한 운동 신호대로 인공 발성기관에서 영어 문장을 합성했다. 이를 영어권 사람들에게 들려주자 70%를 이해했다.

|

그래픽=김하경 |

<이미지를 클릭하시면 크게 보실 수 있습니다> |

연구진은 생각을 읽는 기계가 뇌졸중이나 파킨슨병, 루게릭병(근위축성 측색 경화증) 등 중증 뇌질환으로 온몸이 마비돼 말을 하지 못하는 환자들에게 큰 도움을 줄 것으로 기대했다. 루게릭병을 앓다가 지난해 세상을 떠난 스티븐 호킹 박사는 생전 뺨의 근육을 움직여 1분에 겨우 단어 10개를 컴퓨터에 입력할 수 있었다. 창 교수 연구진은 이번에 분당 150단어를 합성해냈다. 알파벳 b와 p처럼 비슷한 발음은 아직 정확하게 구분하지 못하지만 남녀의 음성 차이와 억양, 속도까지 그대로 복사했다.

생각을 읽는 기계는 이번이 처음이 아니다. 이전에도 뇌에 전극을 이식하고 특정 단어를 생각할 때 나오는 뇌 신호의 패턴을 분석했다. 하지만 이런 방식으로는 분당 8단어 정도를 합성하는 데 그쳤다. 창 교수팀은 뇌에서 어떤 단어를 처리하는지 알아보는 대신 뇌가 발성기관으로 어떤 단어를 말하라고 보내는 신호를 포착해 효율을 극대화했다. 말하자면 보안이 엄격한 작전상황실을 염탐하는 대신, 일선 부대로 보내는 명령문을 간단하게 가로채는 방식을 택한 것이다.

뇌 영상으로 생각을 읽는 방식도 연구되고 있다. 미국 버클리 캘리포니아대의 잭 갤런트 교수 연구진은 2016년 네이처지에 뇌의 단어 지도를 발표했다. 이를테면 '달(month)'이나 '주(week)'처럼 같은 맥락의 단어들이 뇌 어느 곳에서 처리되는지 알아낸 것이다. 연구진은 7명의 자원자에게 인터넷 방송 2시간분을 녹음해 들려주며 동시에 기능성자기공명영상(fMRI)을 촬영했다. 뇌의 특정 영역이 활동하면 에너지 소비가 늘면서 그쪽으로 혈액 공급이 늘어난다. fMRI는 그런 곳을 불이 켜진 것처럼 환하게 보여준다.

페이스북도 생각만으로 분당 100단어 정도가 입력되는 기술을 개발하고 있다. fMRI는 소셜 미디어 사용자들이 일상적으로 사용하기엔 비싸고 번거롭다. 과학자들은 근적외선분광계(fNIRS)를 대안으로 제시했다. 적외선은 피부와 뼈를 통과하지만 혈액 속 헤모글로빈에는 흡수된다. 이를 이용하면 fMRI처럼 뇌 어디가 활발하게 작동해 피가 몰리는지 알 수 있다. 페이스북은 수영 모자 형태의 두건을 쓰고 적외선을 뇌에 쏘는 방식을 고려하고 있는 것으로 추정된다.

◇기억 속 영상도 인공지능으로 복원

최근 인터넷의 주요 정보가 문자에서 영상으로 바뀌고 있다. 생각을 읽는 기술도 마찬가지다.

일본 교토대의 가미타니 유키야스 교수는 지난 1월 국제학술지 '플로스 계산생물학'에 "사람이 어떤 사물을 봤는지 뇌 영상으로 알아내는 인공지능 알고리듬을 개발했다"고 밝혔다. 심지어 보지 않고 상상만 한 영상도 복원해냈다.

연구진은 실험 참가자들에게 1000장 이상의 사진을 보여주면서 fMRI 촬영을 했다. 이를 통해 뇌에서 혈류량의 변화를 2㎜ 해상도로 알아냈다. 이후 인공지능으로 사진의 각 화소가 뇌 혈류량의 변화와 어떻게 연결되는지 파악했다. 나중에 특정 fMRI 영상을 주고 인공지능에 그에 맞는 이미지를 만들게 했다. 사람들은 이 이미지가 두 장의 사진 중 어느 쪽에 가까운지 99% 정확도로 알아냈다. 이를테면 코끼리인지 기린인지 정도는 쉽게 구분했다는 말이다. 앞서 오리건대 연구진은 같은 방법으로 기억 속 얼굴 사진을 복원하는 데 성공했다.

생각을 읽는 기술은 마비 환자를 세상과 다시 이어지게 할 수 있다. 목격자의 기억을 되살려 범죄 수사에도 도움을 줄 수 있다.

하지만 일부에서는 심각한 사생활 침해를 우려한다. 실제로 중국의 한 물류 회사는 작업모 안에 뇌파를 읽는 두건을 쓰게 하고 있다. 뇌의 집중력과 피로도를 미리 파악해 생산성을 올리려는 것이지만, 생각까지 통제받는다는 비판이 나온다.

이영완 과학전문기자(ywlee@chosun.com)

<저작권자 ⓒ ChosunBiz.com, 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.