|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

애플제공이 10일(현지시간) 미국 캘리포니아주 쿠퍼티노 스티브잡스 극장에서 신형 아이폰11과 아이폰11 프로, 아이폰11 프로 맥스를 공개했다.

올해도 어김없이 아이폰 11에 대한 국내외 미디어들 반응은 ‘더 이상 혁신이 없다’, ‘아이폰 XR에서 크게 바뀌지 않아’, ‘애플이 한계에 다다랐다’, ‘5G 네트워크를 지원하지 않아’ 등이다.

특히, 후면 듀얼·트리플 카메라를 사각형 안에 모아 놓은 것을 두고 국내외 네티즌들은 ‘인덕션이다’, ‘방독면 같다’며, 조롱과 혹평을 쏟아내고 있다.

그런데 애플 주가 동향이 이상하다. 애플은 11일 (현지 시간) 시가 총액이 또다시 꿈의 1조 달러를 돌파했다. 애플은 지난 해 8월 사상 처음으로 시가총액 1조 달러를 기록한 바 있다.

주가 반등에 애플 TV 플랫폼과 게임 플랫폼인 아케이드(Arcade) 등 컨텐츠 서비스 시장의 기대감 때문이라는 분석이 나오고 있다. 하지만 아이폰은 아직 최전방에서 애플을 이끌고 있다. 아이폰11에 대해 좀 더 집중해서 알아보자.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

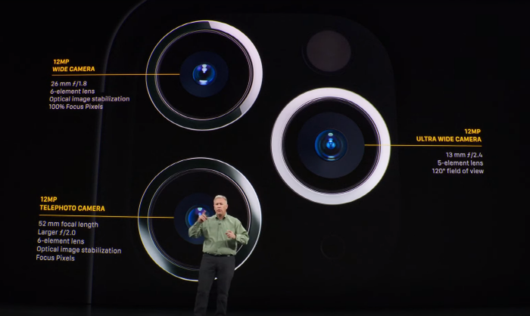

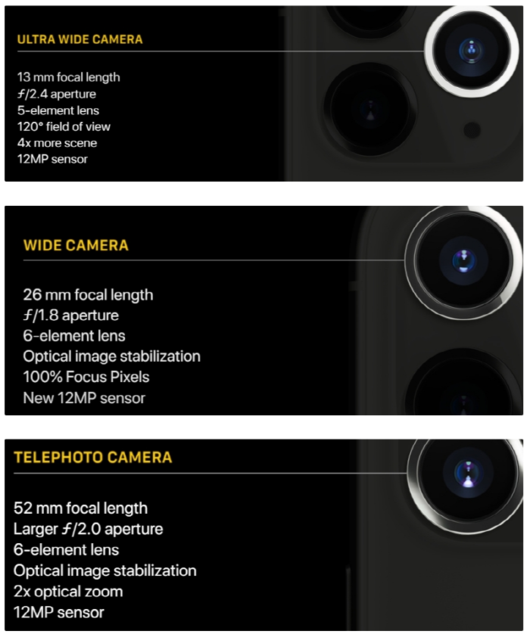

이날 애플은 아이폰11 소개의 절반 이상 시간을 카메라 성능 설명에 할애했다. 아이폰 11은 1,200만 광각, 1,200만 초광각 듀얼 카메라로 구성됐다. 아이폰 11 프로와 프로맥스는 여기에 1,200만 망원 카레라는 더해 트리플 카메라가 장착됐다.

특히 전‧후면 카메라가 동시에 사진과 영상 촬영하고, 4배 줌, 오디오 줌 기능 등을 도입했다. 컴컴한 환경에서도 선명한 사진을 찍을 수 있는 ‘나이트모드’ 기능과 동영상은 4K 화질에 60fps를 지원하며 슬로우 모션 촬영도 가능하다.

또한 초당 1조 연산을 할 수 있는 애플 자체 7nm 공정의 AP(Application Processor, 스마트폰 중앙처리장치) 칩 A13 바이오닉을 탑재해 머신러닝 기술로 픽셀 단위 이미지 편집 기술 ‘딥 퓨전’ 기능을 탑재했다. 이는 사용자가 셔터를 누른 순간에 9장의 사진을 바로 촬영하고 자동으로 합성해 2,400만 화소 수준의 사진을 자체 제작하는 기술이다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

■ 뛰어난 카메라 기술은 어디로 향하나

국내외 미디어들은 아이폰11 출시를 두고 “3세대 연속 같은 폼팩터(Form factor, 제품형태)로 밀고 나가고 있으며, 이미 경쟁사에서 나온 기술이다”고 평가했다.

하지만, 얼핏 비슷한 기능으로 보이지만 디테일에서 다르다. 지금까지 애플의 혁신은 기존의 기술을 다시 새롭게 적용하면서 만들어져 왔다.

가령 3개의 후면 카메라는 2018년 화웨이가 출시한 스마트폰 P20 프로처럼 가로 배치가 디자인 측면에서 최적으로 보일 수 있다. 하지만 애플은 카메라를 사각 박스에 모아 놓았다. 이를 두고 ‘군용장비’처럼 보인다는 의견도 있다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

애플은 2020년에 출시할 예정인 아이폰 12에 방점을 찍고 있는 것으로 보인다. 애플은 아이폰 12로 세상을 바꿀 것이라는 목표 아래 5G 네트워크에 증강현실(AR) 기능이 탑재될 것으로 예측된다. 따라서 카메라가 ‘전문장비’이어야 한다.

또 왜 이번 아이폰 11에 5G를 탑재하지 않았을까. 그 배경에는 5G는 아직 시장에 범용된 기술이 아니기 때문이다. 지금까지 애플은 완벽하지 않은 환경에서 관련 기술을 선보이지 않았던 기업문화가 자리하고 있다.

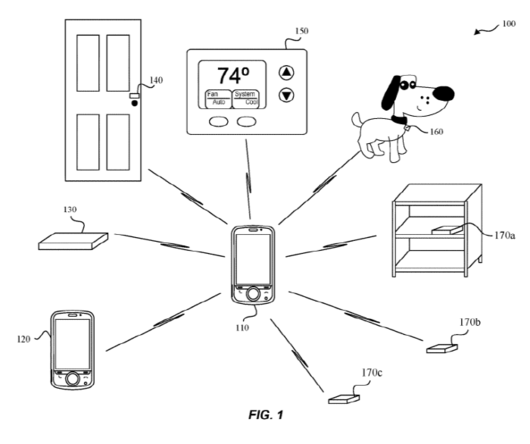

■ U1 칩은 ‘애플의 비밀 무기’

한편, 아이폰11 발표에서 아예 빠진 ‘U1 칩’을 주목해야 한다. U는 초광대역(Ultra Wideband, UWB) 기술을 의미한다. 공식 웹사이트에는 “주변을 인식하는 초광대역 기술’로 U1을 탑재한 다른 아이폰의 위치를 정확하게 감지한다”고 소개하고 있다.

가령 에어드롭으로 공유할 때, 공유할 아이폰 사용자에게 아이폰을 향하면 그 사람을 목록에서 가장 먼저 보여준다. 스마트홈 ‘홈킷(HomeKit)’ 서비스에서는 U1 칩을 활용해 각종 기기를 서로 연결할 수 있다.

특히 U1 칩은 증강현실(AR)에서 매우 중요한 위치를 차지한다. 애플이 AR에 공을 들이고 있다는 건 잘 알려진 얘기다. AR은 애플 태그와 쉽게 결합할 수 있는 기술이다. AR을 활용하면 홈킷에서 보이지 않는 곳의 위치를 3차원으로 자세하게 표시할 수 있다.

예를 들면 홈킷과 연동하는 블라인드가 작동 중인 상황을 AR로 표시해 직접 보지 않고도 제대로 작동하고 있는지 확인할 수 있다. 즉, 스마트홈과 AR을 통합하는 핵심 연결 고리가 U1 칩인 셈이다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

애플은 10여 년 전부터 UWB 관련 특허를 다수 보유하고 있다. U1 칩은 실내에서 오차 10cm 이내의 정밀도를 자랑하는 'IR-UWB(Decawave impulse radio ultra-wideband)‘와 비슷한 기술인 것으로 알려졌다.

IR-UWB를 탑재한 DW1000 Radio IC 칩셋은 Wi-Fi나 블루투스보다 100배 높은 정밀도로 연결 가능 거리는 290m. 전송 속도는 최대 6.8Mbps다.

관련 전문가들은 “소프트웨어 기술과 결합해 실내 위치 오차가 3cm 이내의 정확도일 가능성이 있다”고 말했다.

U1 칩은 손톱보다 작은 초소형 크기여서 아이폰11뿐만 아니라 신형 애플워치나 에어팟 등에 탑재될 것으로 예상되고 있다.

오는 9월 30일 출시 예정인 iOS 13은 ‘정확한 실내 지도 제공’, ‘AR 글래스를 위한 포석’ 등 다양한 예측이 나오고 있다. U1 칩은 ‘애플의 비밀 무기’일 수 있다.

애플은 iOS 13 출시 이후 곧바로 애플 태그가 공식적으로 발표할 것으로 예상된다. 만약 올해에 공개가 이뤄지지 않더라도 2020년 개발자 행사인 WWDC에서는 발표될 가능성이 크다.

그간 애플은 AP인 A 시리즈 바이오닉 칩뿐만 아니라 W 칩 시리즈, H 칩 시리즈 등 자체 라이센스를 확보한 칩 개발에 전념해 왔다. 또 지난 7월에는 애플이 인텔의 모뎀칩 사업부를 약 10억 달러(한화 약 1조1800억 원)에 인수한 것으로 알려졌다.

이는 앞으로 애플 생태계를 제어하는 데 있어 칩이 중요한 역할을 염두에 둔 것으로 해석된다. 즉 애플의 최종 목적지인 3차원(3D) 전략 중 하나로 자체 칩 확보에 집중하고 있다.

그렇다면 왜 카메라 3개를 가로 또는 새로 배치가 아닌 사각 박스에 정삼각형 모양으로 배치했는지 눈치가 빠른 독자들은 바로 알 수 있을 것이다. 또 비가 오거나 어두워도, 멀리 더 넓게 촬영을 해야 하는지도 이해할 수 있을 것이다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

■ 공간을 3D로 맵핑

사람의 3D 입체 영상을 인지하는 원리는 사람의 눈 양쪽 사이가 약 6.5cm 떨어져 있기 때문에 서로 다른 영상을 인식하고, 이 두 가지 영상을 뇌에서 통합, 인지하는 과정에서 입체감을 느끼게 된다.

구글 프로젝트 탱고(Project Tango) 경우도 스마트 기기의 거리센서, 고급 컴퓨터 시각인식 및 이미지 처리 기능으로 공간을 3D로 스캔 맵핑하는 기술이다.

프로젝트 탱고 3D 맵핑은 3가지 동작 원리가 있다. 먼저 ‘모션 추적의 동작 원리’는 광각 카메라를 사용해 회전 및 선형 가속을 예측한다. 이는 움직이는 물체를 찾는 패턴 인식 유형에 사용된다.

‘공간 학습 동작 원리’는 카메라와 안드로이드 위치 서비스를 사용해 실내 위치를 구체화한다. 실제 공간의 가장자리나 모서리, 기타 독특한 시각적 특징을 수집해 실제 위치를 나중에 다시 인식한다. 특히 클라우드 서비스를 사용하지 않고 기기 자체 색인에서 식별한 시각적 특징에 대한 수학적 알고리즘을 기기에 저장해 현재 보이는 공간을 이전에 본 공간과 빠르게 일치시킨다.

마지막으로 ‘거리 인식 동작 원리’는 기기에서 물체까지의 거리를 측정하는 통합 3D 센서가 장착됐다. 또한 거리 데이터는 색상 이미지 데이터와도 연결해 거리 지도를 생성한다. 거리 지도는 촬영한 이미지의 초점을 다시 맞추는 것과 같이 고유한 방식으로 사진을 수정해 이미지를 최적화한다.

하지만 거리 인식 기술은 기기의 카메라의 근적외선을 인식하는 기술에 의존하고 있어 한계가 있다. 햇빛이나 백열등 전구와 같이 적외선 광원이 높은 곳에 있는 공간이나 적외선을 반사하지 않는 물체는 정확하게 감지할 수 없는 단점이 있다.

한편, 구글은 지난해 3월 ‘프로젝트 탱고’를 접고 2017년 8월에 공개한 AR 개발자 툴 ‘AR 코어(Core)’를 통해 모든 안드로이드 스마트폰에 AR을 적용한다는 계획이다. 현재 애플 ‘AR 개발자 툴(AR Kit)’과 경쟁하고 있다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

■ 2020년 아이폰12, 공간 3D 맵핑 전 단계

결론은 아이폰11의 뛰어난 성능의 3개의 카메라(광각, 망원, 초광각) 위치가 사람의 두 눈 사이의 간격((Interocular Distance)처럼 정밀하게 계산된 배치로 보인다. 여기에 A13 딥러닝을 통한 딥 퓨전 기술과 U1 칩 기술 등 하드웨어와 소프트웨어가 결합해 사물을 인식하고 공간을 3D로 맵핑하는 방향으로 가는 전 단계로 분석된다.

그간 애플은 세상을 모두 3D로 스캔하겠다는 목표를 위해 끊임없이 앞으로 나가고 있다. 또한 이를 운영하기 위한 OS 개발도 더불어 진행하고 있는 것으로 보인다.

아스팩미래기술경연구소 차원용 대표 소장은 최근 발간한 <애플의 3D 전략 특허 분석> 보고서에서 “애플이 추진하는 3D 아바타(Avatar)/모델(Model)과 3D GUI/GUX의 AR/VR 등이 출시되려면 기본적인 OS가 3D OS가 되어야 한다”며, “이 같은 가설 아래 애플의 관련 특허를 분석한 결과 기존 2D의 맥(Mac) OS/iOS를 3D GUI의 OS/앱(App)/사파리(Safari)로 업그레이드될 것”이라고 내다봤다.

이번 아이폰11은 스마트폰 10년 이후 새로운 게임 체인저(Game Changer)가 나올 수 있는 단초를 보여주고 있어 2020년 아이폰12의 기대감을 높이고 있다.

김들풀 기자 itnews@

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.